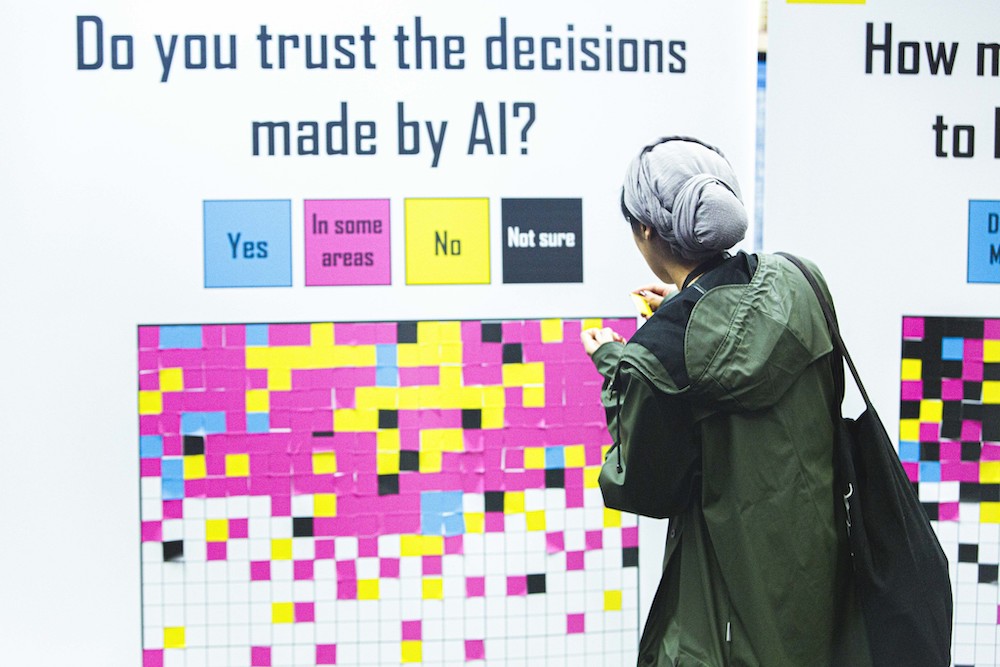

Una exposición en MozFest 2019 hace la pregunta: "¿Confías en las decisiones tomadas por la IA?" Foto: Mozilla Festival/Flickr (CC BY 2.0)

Ayer, las autoridades prohibieron otra protesta anunciada por el grupo activista Rouge One. Esta es la segunda ocasión en la que se prohíbe una protesta anunciada debido a que AuRii —un algoritmo gubernamental de análisis predictivo— hizo una “predicción bastante exacta de que habría violencia durante la protesta”. AuRii ha analizado tuits sobre la protesta anunciada durante las últimas 24 horas y su veredicto parece claro: hay un 86 % de probabilidades de violencia. Los activistas están consternados por esta violación de sus derechos y exigen una investigación. Además, hay indicios de que algunos bots son los responsables de los tuits relacionados con la violencia, lo que apunta a un sabotaje organizado de las actividades de Rouge One. A pesar del clamor público, las autoridades se han mantenido firmes en que no pueden revelar el funcionamiento analítico interno de AuRii, mientras que el tribunal trata de desentrañar su proceso de toma de decisiones.

Si nunca ha oído hablar de AuRii, no se preocupe. Esta noticia es ficticia. Sin embargo, su premisa se vuelve cada vez más probable, a medida que se utilizan más sistemas de inteligencia artificial en la esfera pública de toma de decisiones. En el estudio “Moralization in social networks and the emergence of violence during protests” (La moralización en las redes sociales y el surgimiento de la violencia durante las protestas), que utilizó datos de las protestas en Baltimore de 2015, los investigadores crearon un algoritmo que puede predecir un vínculo entre los tuits y la acción en las calles, horas antes de que haya violencia. Otro estudio, realizado por el Laboratorio de Investigación del Ejército de EE. UU., concluyó que las protestas posteriores a las elecciones de 2016 se podrían haber pronosticado mediante el análisis de millones de publicaciones en Twitter. Estas clases de análisis predictivos afectan nuestros derechos a expresar opiniones y reunirnos: la policía puede utilizarlos para planificar su respuesta a los eventos disruptivos y evitarlos, pero también para sabotear la expresión y el activismo públicos legítimos, o silenciar la disidencia. Es inevitable que las reuniones públicas causen disrupciones, pero las autoridades deben aceptarlas, ya que las normas internacionales estipulan que la protección del orden público no debe restringir innecesariamente las reuniones pacíficas. Entonces, ¿cómo podrían utilizarse los sistemas algorítmicos de manera segura en el ámbito público? ¿En qué medida se pueden usar los resultados generados a partir de algoritmos como evidencia para restringir las libertades y los derechos?

Todos los días nos enteramos de ejemplos del uso, real o potencial, de sistemas algorítmicos en la toma de decisiones públicas, desde la vigilancia por reconocimiento facial para establecer una “buena reputación” hasta los modelos automatizados de cálculo de riesgos en materia de prestaciones de asistencia social y de otro tipo que disuaden a los activistas. Mozilla Foundation y Elements AI afirman que el derecho público a recibir una explicación ya existe cuando un sistema algorítmico fundamenta una decisión que tiene un efecto importante en los derechos, intereses financieros, salud personal o bienestar de una persona.

En realidad, nadie sabe exactamente cuáles pueden ser los efectos sobre nuestros derechos y libertades. De acuerdo con la recomendación del Consejo de Europa, los Estados deben asumir la responsabilidad de establecer marcos apropiados de legislación, regulación y supervisión, así como realizar evaluaciones del impacto en los derechos humanos en cada etapa del proceso de desarrollo, implementación y evaluación. Además, los sistemas algorítmicos diseñados por empresas privadas para su uso en el sector público deben incluir salvaguardias de transparencia en sus términos de referencia. Por ejemplo, las autoridades pueden exigir que el código fuente se ponga a disposición del público. Investigadores del Instituto Alan Turing en Londres y la Universidad de Oxford llaman al escrutinio para que el público pueda ver cómo un algoritmo tomó realmente una decisión, cuando esas decisiones afectan a la vida de las personas.

¿En qué medida se pueden usar los resultados generados a partir de algoritmos como evidencia para restringir las libertades y los derechos?

En el Mozilla Festival de 2019, ECNL organizó un debate acerca de los efectos de los algoritmos sobre nuestra libertad de reunión y de protesta con un grupo de abogados, activistas, tecnólogos y académicos. Proponemos varias medidas paralelas para garantizar la protección y promoción de nuestros derechos:

(1) En primer lugar, obtener acceso para conocer cómo se diseñan y utilizan los sistemas algorítmicos a fin de entender sus efectos existentes y potenciales sobre los derechos a la libertad de reunión, asociación, expresión y participación, y explorar las posibilidades de usarlos para el bien. Esto se puede lograr, por ejemplo, creando una plataforma de colaboración masiva sobre “sistemas de IA para las libertades cívicas”, que permita canalizar información sobre las formas en que los gobiernos, las empresas o las organizaciones utilizan la tecnología y los sistemas algorítmicos. Los activistas cívicos, los desarrolladores, los académicos y las organizaciones podrían subir ejemplos de prácticas en las que se han utilizado o podrían utilizarse sistemas de IA que repercutan en las libertades cívicas básicas. Estos aprendizajes se pueden esquematizar e investigar más a fondo para fundamentar las políticas, las acciones de promoción y la creación de directrices prácticas sobre cómo proteger y promover estos derechos. Las plataformas existentes, como el Observatorio de Políticas de IA de la OCDE, podrían ayudar a facilitar esos esfuerzos.

2) En segundo lugar, necesitamos afrontar los desafíos fundamentales: cómo trasladar de forma práctica los derechos humanos al diseño de sistemas algorítmicos, para lograr un diseño centrado en los derechos humanos. Según el equipo de investigación de la Universidad de Birmingham, de esta manera los sistemas algorítmicos serían compatibles con los derechos humanos y reflejarían los valores esenciales que sustentan el estado de derecho. El equipo propuso traducir las normas de derechos humanos en procesos de diseño de software y requisitos de sistemas, admitiendo que algunos derechos serán más fáciles de convertir (como el derecho al debido proceso, el derecho a la privacidad y los derechos a la no discriminación), mientras que es probable que otros sean difíciles de “instalar permanentemente”, como el derecho a la libertad de expresión, conciencia y asociación. Es precisamente por estas dificultades por lo que este esfuerzo requiere de la investigación y estrecha colaboración entre especialistas técnicos y expertos jurídicos.

Es preciso desarrollar redes más amplias de creación de conocimientos e intercambiar aprendizaje sobre la puesta en práctica.

(3) En tercer lugar, necesitamos reforzar las garantías jurídicas mediante las políticas y la promoción de normas jurídicas matizadas y orientaciones sobre la tecnología y los derechos humanos en los tratados internacionales y marcos regionales. Ya se están desplegando esfuerzos en este sentido en las Naciones Unidas y a nivel europeo. Tanto el Consejo de Europa como la Unión Europea están decididos a proponer por primera vez una reglamentación relativa a la IA en el plazo de un año, lo que podría servir de referencia positiva para el resto del mundo, ya que probablemente se basarán en las normas europeas existentes en materia de derechos humanos, la democracia y el estado de derecho. Por otra parte, la UE pretende utilizar el acceso a su mercado como palanca para difundir el enfoque europeo sobre la reglamentación de la IA en todo el mundo. Sin embargo, debemos asegurarnos de mantener estándares altos y de que todos los posibles sistemas de IA que afecten los derechos humanos se incluyan en estos reglamentos. Esta experiencia puede ayudar a configurar otros procesos de establecimiento de normas, así como las próximas evaluaciones de las repercusiones en los derechos humanos de los sistemas de IA o de las estrategias y planes nacionales en la materia. El informe Closing the Human Rights Gap in AI Governance (Cómo cerrar la brecha de derechos humanos en la gobernanza de IA) ofrece un conjunto de herramientas prácticas.

(4) Por último, es urgente celebrar consultas coherentes, inclusivas, significativas y transparentes con todas las partes interesadas. En específico, se debe incluir a la sociedad civil más amplia, organizaciones y movimientos de derechos humanos, académicos, medios de comunicación e instituciones educativas. A fin de que estos esfuerzos sean eficaces, es necesario invertir tiempo y recursos para que las partes interesadas participen en las conversaciones sobre el desarrollo y la implementación de estrategias nacionales de IA, el despliegue, la implementación y la evaluación de los efectos de los sistemas de IA, sobre todo cuando se utilizan en los servicios públicos, así como programas educativos gratuitos para el público sobre qué es la IA y cómo puede beneficiar a las sociedades. El público necesita entender, conocer y debatir al menos las consecuencias básicas de la aplicación de sistemas algorítmicos que repercuten en nuestras vidas.

En resumen, es preciso desarrollar redes más amplias de creación de conocimientos e intercambiar aprendizaje sobre la puesta en práctica. Estas acciones también requieren superar las formas tradicionales de cooperación: debemos colaborar más allá de las divisiones y entre campos especializados. El hecho de que el Mozilla Festival confiara en que un grupo de abogados sería capaz de organizar una sesión relacionada con la tecnología es un ejemplo de ello.