L’intelligence artificielle. Tout le monde en parle, nombreux prétendent la comprendre, mais combien d’entre nous mesurent vraiment son potentiel disruptif ? Sans être aussi alarmiste que Yuval Noah Harari (qui qualifie l’essor de l’IA et de la bio-ingénierie de menace existentielle pour le genre humain, au même niveau que le risque de guerre nucléaire et le changement climatique) le fait que l’IA puisse bouleverser notre façon de vivre est bien réel, pour le meilleur et pour le pire.

Il est évident qu’il est aujourd’hui nécessaire de commencer à réglementer le développement d’une technologie aussi disruptive que l’IA et de nombreuses initiatives voient déjà le jour dans les entreprises et au sein de la société civile afin d’orienter le développement et l’utilisation « éthiques » de cette technologie. Mais pourquoi parlons-nous d’éthique plutôt que de droit et de droits humains ?

L’impact potentiel de l’IA

L’IA est une technologie incroyablement prometteuse en tant que moteur du progrès social, mais elle peut également nuire aux droits et aux libertés fondamentales. Un exemple fréquemment cité est la discrimination qui résulte des préjugés des algorithmes car les données historiques utilisées dans l’apprentissage des algorithmes reflètent et perpétuent les préjugés humains. Notre vie privée est également menacée d'être surveillée plus étroitement. De récents scandales ont montré que la désinformation peut être facilitée par des « bots » malveillants (qui génèrent de faux contenus) et par des algorithmes de réseaux sociaux générés par l’IA (qui mettent en avant les contenus populaires).

Lignes directrices en matière d’éthique pour l’IA

Nombreux sont ceux qui ont appelé à ce que la réglementation de l’IA repose sur les droits humains, notamment dans la Déclaration de Toronto sur la protection du droit à l’égalité et à la non-discrimination dans le domaine de l’apprentissage (mai 2018) qui a été saluée comme « une première étape visant à faire des droits humains un élément fondamental de l’IA et de l’éthique des données ».

Cependant, jusqu’à présent, le débat a principalement porté sur des lignes directrices « éthiques » plutôt que sur un cadre juridique ou sur les droits humains. Dans un contexte géopolitique marqué par une concurrence technologique intense entre l’Europe, les États-Unis et la Chine, le défi consiste à élaborer un cadre réglementaire qui contrôle les excès potentiels sans brider l’innovation, ce qui peut expliquer la préférence pour des lignes directrices « éthiques » qui sont moins spécifiques.

Cette approche est moins surprenante concernant les initiatives prises volontairement par les entreprises : la principaux acteurs impliqués dans l’IA, notamment Google, Microsoft et IBM, ont publié des principes éthiques pour le développement de leur technologie d’intelligence artificielle.

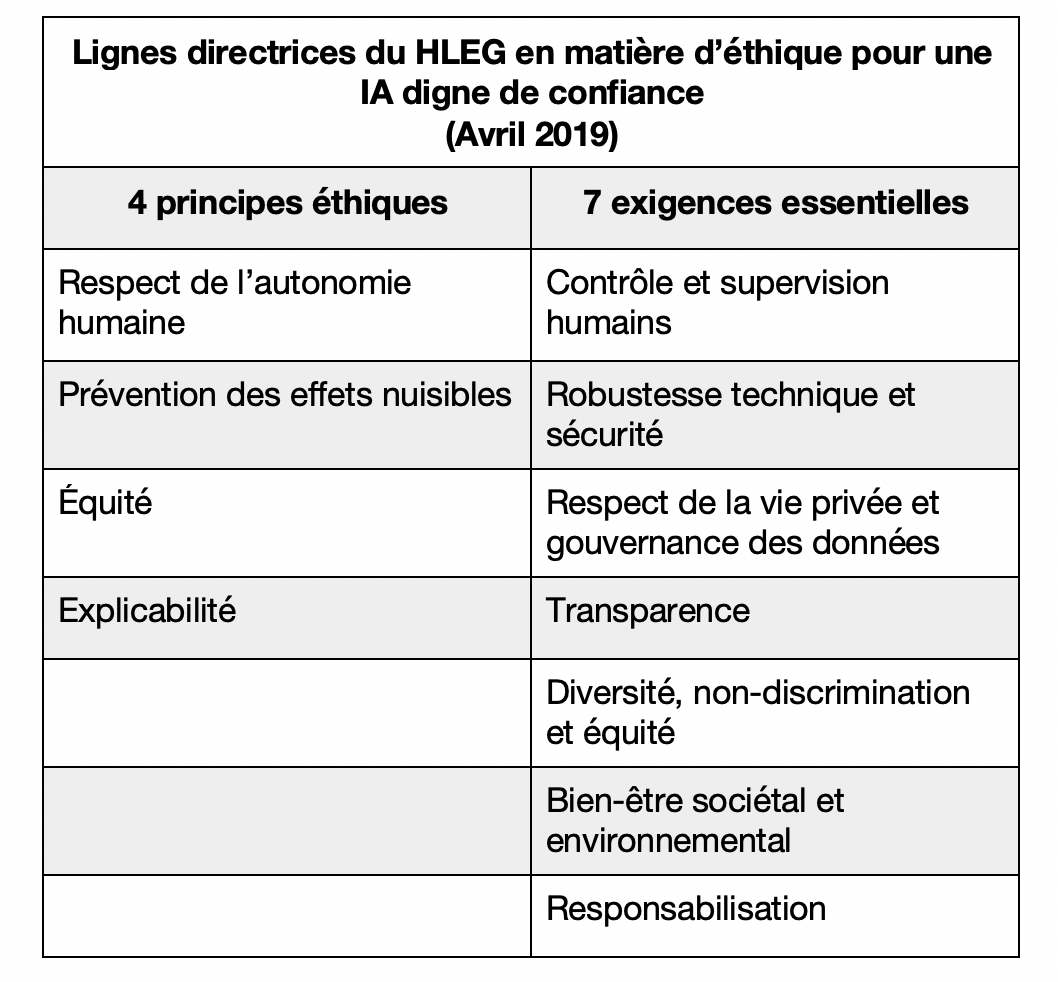

Cependant, le soutien en faveur d’un cadre « éthique » a récemment été réaffirmé par le Groupe d’experts de haut niveau sur l’intelligence artificielle (HLEG) de la Commission européenne. Suite à une vaste consultation, le HLEG a publié des « lignes directrices en matière d’éthique pour une IA digne de confiance » destinées à guider les acteurs impliqués dans l’IA dans le développement et l’utilisation responsables d’une IA « digne de confiance », définie comme une IA licite, éthique et robuste. Bien que les lignes directrices soient « basées » sur les droits fondamentaux inscrits dans le droit européen et international, elles sont fondées sur quatre principes éthiques reposant sur sept exigences essentielles qui font parfois écho aux concepts des droits humains sans avoir toutefois de définition précise.

Bien que les lignes directrices de l’UE reconnaissent la portée mondiale de l’IA et incitent à la création d’un cadre international fondé sur les droits humains, elles sont également explicitement destinées à favoriser l’innovation européenne et son leadership dans l’IA. Dans ce contexte, le discours éthique peut avoir été plus incitateur que celui portant sur la protection des droits humains. D’après le HLEG, la priorité était d’aller rapidement afin de rester en phase avec le débat sur l’IA et d’y contribuer. De plus, les lignes directrices de l’UE n’étaient pas destinées à se substituer à la réglementation (sur laquelle le HLEG est par ailleurs chargé d’adresser des recommandations à la Commission de l’UE). En effet, les concepts éthiques, comme ceux d’équité ou de transparence, sont flous et dépendent d’un contexte culturel donné, laissant la porte ouverte à des interprétations diverses et des niveaux de protection variés. Les lignes directrices de l’UE reconnaissent les « nombreuses interprétations différentes de l’équité » tandis que les principes de Google sur l’IA « reconnaissent que faire la distinction entre des a priori justes et injustes […] diffère selon les cultures et les sociétés ». Comment des notions aussi subjectives que celle « d’équité » peuvent-elles nous dire quels sont les risques pour les individus qui pourraient être justifiés au regard des effets sociétaux bénéfiques de la reconnaissance faciale ? Ou bien à quel moment la responsabilité d’une entreprise devrait-elle être engagée lorsqu’elle n’arrive pas à réduire suffisamment les a priori injustes dans ses algorithmes ? Et quelle est l’utilité de principes culturellement relatifs lorsqu’il s’agit de surveiller le développement d’une technologie dont la portée est mondiale ?

Bien que les lignes directrices de l’UE reconnaissent la portée mondiale de l’IA et incitent à la création d’un cadre international fondé sur les droits humains, elles sont également explicitement destinées à favoriser l’innovation européenne et son leadership dans l’IA. Dans ce contexte, le discours éthique peut avoir été plus incitateur que celui portant sur la protection des droits humains. D’après le HLEG, la priorité était d’aller rapidement afin de rester en phase avec le débat sur l’IA et d’y contribuer. De plus, les lignes directrices de l’UE n’étaient pas destinées à se substituer à la réglementation (sur laquelle le HLEG était par ailleurs chargé d’adresser des recommandations à la Commission de l’UE – celles-ci ayant été publiées le 26 juin 2019).

Mais si nous sommes d’accord que l’IA doit être réglementée (par le biais de lois existantes ou nouvelles) l’UE semble avoir manqué l’opportunité de placer le débat réglementaire à venir sous l’angle des droits humains.

Une approche fondée sur les droits humains ?

Le fait que les principes éthiques soient adoptés avec le soutien des entreprises impliquées dans l’IA est bien sûr positif. Ceci dit, une approche fondée sur les droits humains offrirait un cadre plus robuste pour le développement et l’utilisation licites et éthiques de l’IA.

Les droits humains sont un ensemble de normes acceptées au niveau international qui représentent, dans un langage commun, l’expression la plus universelle de nos valeurs partagées. Ces normes sont soutenues par des mécanismes et des institutions veillant à ce que des comptes soient rendus et des réparations accordées. Les droits humains apportent clarté et structure ainsi que le pouvoir normatif du droit.

Par exemple, le droit relatif aux droits humains fournit un cadre clair pour arbitrer les intérêts concurrents dans le développement de la technologie : sa jurisprudence établie exige que les restrictions aux droits humains (comme le respect de la vie privée ou la non-discrimination) soient prescrites par la loi, poursuivent un but légitime, et soient nécessaires et proportionnées à cet objectif. Chaque terme est un concept défini permettant une évaluation et une responsabilisation objective.

Les lignes directrices de l’UE incitent à penser que l’adhérence aux principes éthiques place la barre plus haut que la stricte conformité avec les lois qui ne sont pas toujours d’actualité avec la technologie ou qui peuvent ne pas être adaptées pour traiter de certaines questions. Cependant, en réalité, l’éthique est bien plus aisément manipulable en faveur des projets d’une entreprise ou d’un gouvernement et ne permet ainsi qu’un recours limité à quiconque serait en désaccord.

Les droits humains offrent un cadre global pour évaluer pleinement l’impact potentiel d’une technologie disruptive comme l’IA sur l’ensemble de nos droits et de nos libertés (civils, politiques, économiques, culturels et sociaux) et ne laissent aucune zone grise.

De plus, ils ont l’avantage d’offrir des normes de bonnes pratiques éprouvées et largement acceptées dans le domaine de la protection et du respect des droits humains, notamment les principes directeurs de l’ONU relatifs aux entreprises et aux droits de l’homme. Par exemple, la diligence en matière de droits humains en vertu des principes directeurs de l’ONU comprend le fait de communiquer sur la manière dont les effets sont identifiés et traités, ce qui revêt une importance encore plus forte quand il s’agit du développement d’une technologie qui est souvent mal (voire pas du tout) comprise. Les détenteurs de droits qui sont affectés doivent également avoir accès à un recours utile. Ce sujet est débattu dans le cadre de l’IA, par exemple en lien avec le « droit à l’explication » de la prise de décision automatisée en vertu du RGPD de l’UE. Mais la forme que devrait prendre ce recours utile est encore floue et pourrait être définie plus précisément à l’aide des principes directeurs de l’ONU l’homme (selon les critères de légitimité, d’accessibilité, de prédictibilité, d’équité et de transparence).

Ce qui ne veut pas dire que le débat et les lignes directrices éthiques devraient être abandonnés mais que les spécialistes des droits humains devraient les utiliser comme base de départ afin d’aller plus loin pour s’assurer d’œuvrer en faveur d’un cadre juridique mondial applicable servant à réglementer la technologie de l’IA tout en étant suffisamment adaptable à un futur qu’il nous reste à imaginer.